百万架构师成长之路(19):【终极实战篇·五】风暴之后:构建系统的“上帝之眼”——全链路可观测性体系

导语:从“黑盒”到“白盒”,当系统拥有了“灵魂”

我们的“雷神之锤”秒杀系统,在经历了蓝图绘制、前哨防御、壁垒构筑和核心流程重塑之后,已经具备了应对流量风暴的强大能力。它就像一头肌肉发达的巨兽,充满了力量。

但是,这头巨兽是沉默的。

当用户抱怨“抢购失败”时,请求究竟死在了漫长调用链路的哪一环?是CDN?是Nginx?是网关的限流?是Redis库存不足?还是订单服务的数据库写入超时?当系统整体响应变慢时,瓶颈究竟是CPU、内存、网络,还是某个下游服务的抖动?当秒杀活动结束后,我们该如何精确地复盘整个过程的流量曲线、资源消耗和潜在风险?

一个没有被充分观测的系统,就是一个“黑盒”。无论其内部设计多么精妙,对我们而言,它都是一个运行在“薛定谔的猫”状态下的、充满不确定性的存在。运维和排障,将变成一场依赖猜测、经验和运气的“玄学”。

本篇,我们的任务,就是打破这个“黑盒”,为这头巨兽注入“灵魂”,让它学会“言说”。我们将深入探索现代分布式系统的基石——可观测性(Observability)。

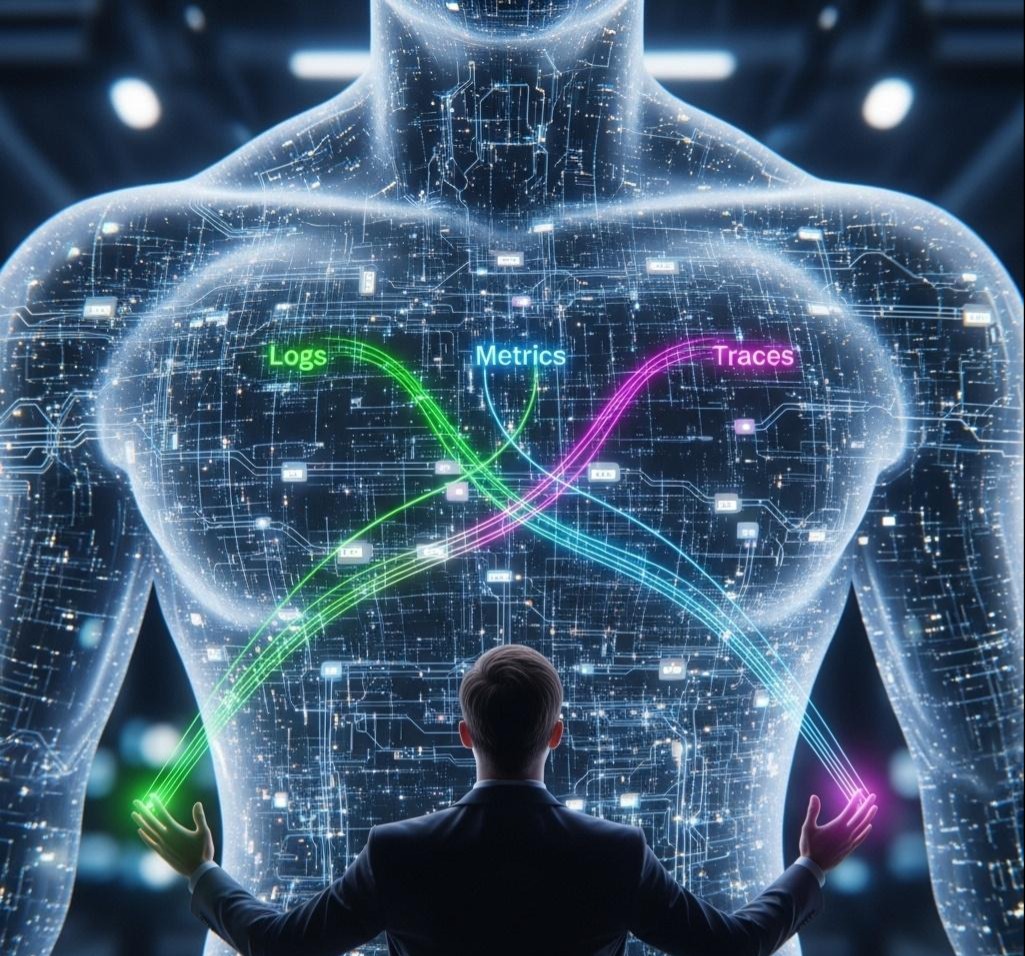

我们将不再把Logging(日志)、Metrics(指标)、Tracing(追踪)视为三个孤立的技术,而是将它们编织成一个三位一体的、能够相互关联、相互印证的“上帝之眼”系统。通过这个系统,我们期望达到这样的境界:任何发生在系统内部的事件,无论多么微小,都能以结构化的、可量化的、可追溯的方式,被我们所感知和理解。

我们将以OpenTelemetry这一云原生时代的事实标准为核心,结合经典的ELK、Prometheus、Grafana、SkyWalking/Zipkin等工具栈,为我们的Java秒杀系统,构建一个完整的、可落地的全链路可观测性体系。

第一部分:思想的变革——从“监控”到“可观测性”

在深入技术细节之前,我们必须完成一次关键的思想转变。长久以来,我们都在谈论“监控(Monitoring)”。监控就像是我们预先在墙上安装好的几个温度计和烟雾报警器。

- 监控的特点: 它是基于已知的。我们提前预设好要监控哪些指标(CPU使用率、内存占用),并为它们设定报警阈值。

- 监控的局限: 它只能回答“是不是”的问题。例如,“CPU使用率是不是超过了90%?”。但它无法回答更深层次的“为什么”——“为什么CPU使用率会突然飙升?”。在复杂的分布式系统中,“未知的未知(Unknown Unknowns)”远比“已知的未知”要多得多。

可观测性(Observability),则是一个更强大的概念。它源于控制理论,指的是仅通过观察系统的外部输出,就能推断其内部状态的能力。一个可观测的系统,允许你提出任意“为什么”和“怎么样”的问题,并能从系统自身产生的数据中找到答案。

如果说监控是给你几个固定的仪表盘,那么可观测性就是给了你一个功能强大的调试器(Debugger),只不过这个调试器是运行在生产环境的、分布式的、百万QPS之上的。

可观测性的实现,依赖于高质量的遥测数据(Telemetry Data),而这些数据,就是我们常说的“圣三一”:Logs, Metrics, Traces。

第二部分:Logging——结构化日志,让机器读懂你的故事

日志,是可观测性体系中最古老,也最基础的一环。但90%的团队,仍在用一种极其低效的方式记录和使用日志。

传统日志的困境:

1 | // 这是最常见的日志格式 |

这种日志,是写给“人”看的。当你要进行故障排查时,你不得不使用grep, awk等工具,在海量的文本文件中,通过复杂的正则表达式去匹配关键词。效率低下,且无法进行聚合分析。

核心战术:结构化日志(Structured Logging)

我们的目标,是让日志首先是写给“机器”看的。我们将每一条日志,都视为一个结构化的JSON对象。

1 | { |

这个JSON对象,可以被直接扔进Elasticsearch这样的搜索引擎中。现在,你可以像查询数据库一样查询你的日志:

- user_id: 123 AND level: ERROR (查询用户123的所有错误日志)

- item_id: 456 AND message: “Stock not enough” (查询商品456所有库存不足的记录)

Java实战:

- 引入依赖 (pom.xml):

1 | <!-- Logback + SLF4J 是Spring Boot的默认日志框架 --> |

- 改造logback-spring.xml:

1 | <configuration> |

- 在代码中注入上下文信息 (MDC):如何将traceId, userId这些动态信息,自动地加入到每一条日志中?答案是SLF4J的MDC(Mapped Diagnostic Context)。它是一个线程级别的ThreadLocal Map。

我们可以编写一个Spring MVC的Interceptor或WebFlux的WebFilter,在请求开始时,从请求头中获取这些信息,放入MDC;在请求结束时,清理MDC。

1 |

|

配置好这个Interceptor后,你在代码中只需要像往常一样打印日志:

1 | log.info("Processing order for item {}", itemId); |

ELK Stack简介:

ELK是三个开源软件的缩写,它们是构建日志分析平台的黄金组合:

- Elasticsearch: 一个基于Lucene的、强大的分布式搜索引擎。负责存储和索引。

- Logstash: 一个数据处理管道。它可以从各种来源(如TCP、文件、Kafka)接收数据,进行解析、过滤、转换,然后发送到各种目的地(如Elasticsearch)。

- Kibana: 一个Web UI界面,提供了强大的数据可视化和查询能力。

通过这套组合,我们把杂乱无章的文本日志,变成了一个结构化、可查询、可分析的“日志数据库”。

第三部分:Metrics——用数字描绘系统的脉搏

如果说日志记录的是“离散的事件”,那么指标(Metrics)记录的就是“连续的状态”。它将系统的运行状况,抽象为一系列可聚合、可计算的时间序列数据。

3.1 指标的四种类型(Prometheus模型)

理解指标,首先要理解它的四种基本类型:

- Counter (计数器): 一个只增不减的累计值。例如,“秒杀订单创建总数”、“服务接收到的总请求数”。它告诉你“发生了多少次”。

- Gauge (仪表盘): 一个可任意变化的瞬时值。例如,“当前JVM堆内存使用量”、“线程池中活跃的线程数”、“商品剩余库存”。它告诉你“现在是多少”。

- Histogram (直方图): 对一段时间内的观测值进行分桶统计。例如,将请求延迟分为**(0-100ms]**, (100-200ms], **(200-500ms]**等多个桶,然后统计落在每个桶里的请求数量。它告诉你“分布情况如何”。

- Summary (摘要): 与直方图类似,但它直接计算并存储分位数(Quantiles),如P50, P90, P99。它直接告诉你“99%的请求都快于X毫秒”。

Histogram vs. Summary 的深度抉择:

- Histogram 更强大,因为它保留了原始的分布信息。你可以在服务端(Prometheus)进行任意的分位数估算和聚合。缺点是客户端需要维护桶,且传输的数据量稍大。

- Summary 在客户端直接计算好分位数,服务端无法再进行聚合(你不能对两个P99的值求平均)。优点是简单直接。

- 最佳实践: 优先使用Histogram,因为它提供了更灵活的后端分析能力。

3.2 核心战术:拥抱Micrometer与Prometheus

1. Micrometer: Java指标的SLF4J

在过去,如果你想接入Prometheus,你需要引入Prometheus的Client库;如果想换成Datadog,又得改代码,引入Datadog的库。Micrometer的出现,终结了这个混乱的局面。

它是一个“指标门面”,定义了一套统一的API(Counter, Gauge, Timer等)。你的应用代码只依赖Micrometer。然后,你只需在运行时,加入具体的“注册表(Registry)”依赖(如micrometer-registry-prometheus),Micrometer就会自动将指标数据转换成对应监控系统的格式。

2. Prometheus: 云原生监控的王者

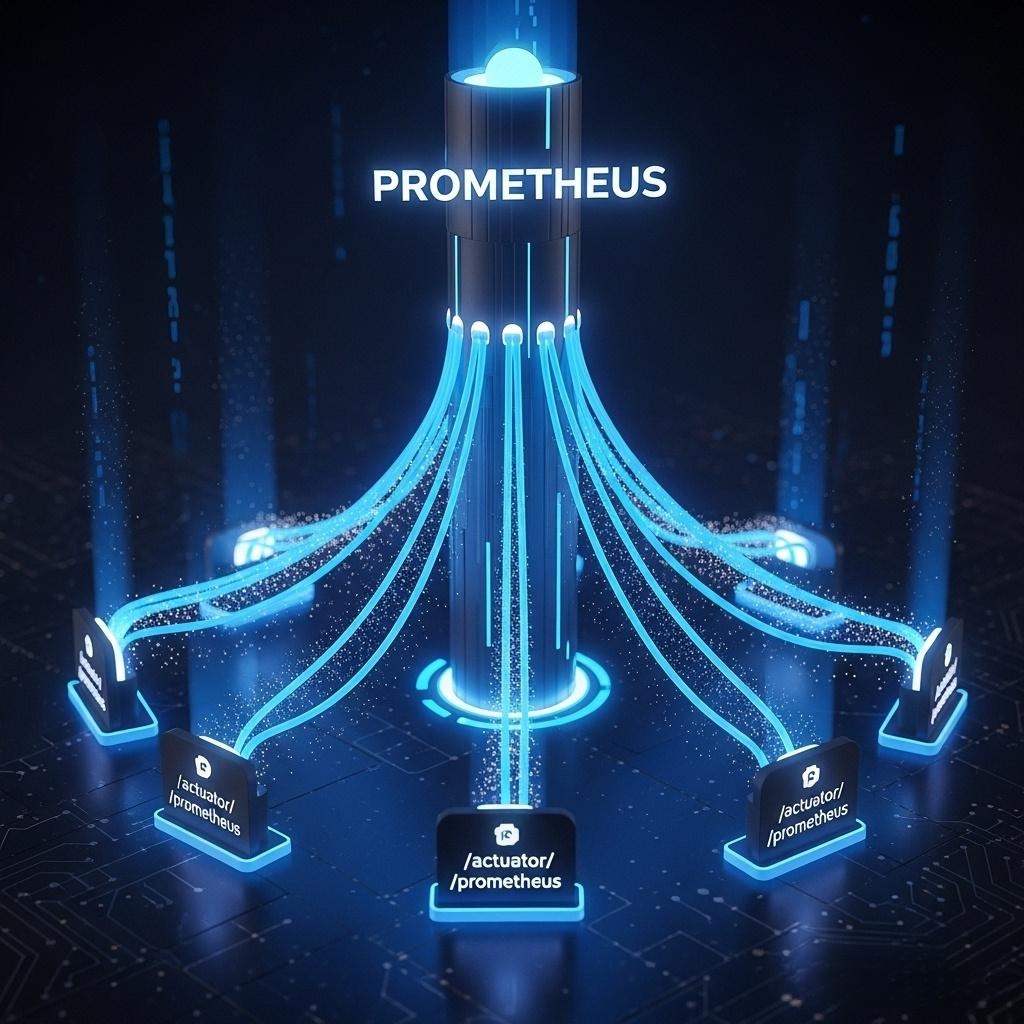

Prometheus以其简洁的Pull(拉)模型和强大的PromQL查询语言,成为了云原生监控的事实标准。

- Pull模型: 你的Java应用只需通过一个HTTP端点(如**/actuator/prometheus**)暴露自己的指标数据。Prometheus Server会定期(如每15秒)来主动“拉取”这些数据。这种模型相比Push模型,架构更简单,中心服务器可以自主控制抓取频率,更易于管理。

3.3 Java实战:为秒杀系统植入“心电图”

- 引入依赖 (pom.xml):

1 | <dependency> |

- 开启Prometheus端点 (application.yml):

1 | management: |

启动应用后,访问http://localhost:8080/actuator/prometheus,你将看到大量由Actuator自动配置好的基础指标,如jvm_memory_used_bytes, http_server_requests_seconds_count等。

- 定制业务指标:现在,我们为Seckill-Core服务添加关键的业务指标。

1 |

|

- 配置Prometheus (prometheus.yml):

1 | scrape_configs: |

- Grafana可视化:在Grafana中,添加Prometheus为数据源。然后新建一个Dashboard,添加Panel,使用强大的PromQL来查询和展示数据:

- 秒杀QPS: sum(rate(seckill_stock_deduct_count_total[1m]))

- 库存扣减成功率: sum(rate(seckill_stock_deduct_count_total{result=”success”}[1m])) / sum(rate(seckill_stock_deduct_count_total[1m])) * 100

- P99延迟: histogram_quantile(0.99, sum(rate(seckill_stock_deduct_duration_seconds_bucket[1m])) by (le))

- iPhone 15剩余库存: seckill_stock_remaining_gauge{itemId=”123”}

通过这套组合拳,我们为秒杀系统构建了一个信息密度极高的实时作战大盘,系统的每一次脉搏跳动,都尽在我们的掌握之中。

第四部分:Tracing——绘制请求的“侦探地图”

Metrics告诉我们“哪个服务慢了”,但Tracing才能告诉我们“为什么慢,慢在了哪一步”。

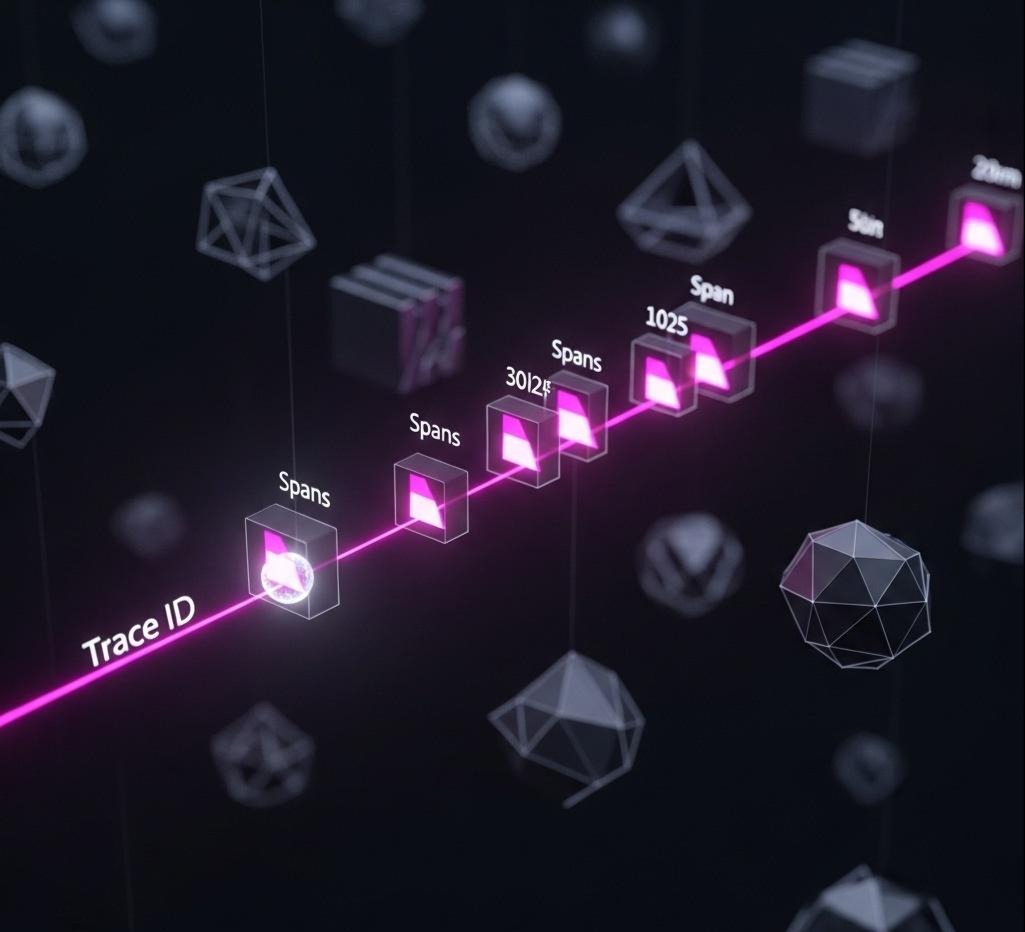

4.1 分布式追踪的核心:Trace ID 与 Span

想象一个秒杀请求的旅程:

用户 -> Nginx -> Gateway -> Seckill-Core -> Redis -> RocketMQ -> Order-Service -> MySQL

- 当这个请求第一次进入我们的系统(如Gateway)时,我们为它分配一个全局唯一的Trace ID。

- 这个Trace ID会像一个“通行证”,通过HTTP Header或RPC的Metadata,在后续的每一次服务调用中被传递下去。

- 请求在每一个服务内部的停留和处理过程,被称为一个Span。每个Span都有自己的Span ID,并记录了它所属的Trace ID以及其父Span的ID。

- 所有的Span通过Trace ID和父子关系,被串联成一棵完整的、有因果关系的调用树。

这棵树,就是我们用来破案的“侦探地图”。

4.2 核心战术:OpenTelemetry一统天下

过去,我们有Zipkin(Brave)、Jaeger(OpenTracing)、SkyWalking等多种互不兼容的分布式追踪方案。OpenTelemetry (OTEL) 的诞生,就是为了终结这场混乱。它提供了一套统一的规范、API和SDK,让你可以一次埋点,数据导出到任何兼容的后端。

而OTEL最强大的地方,在于它的自动探针(Auto-Instrumentation)。

Java Agent的魔力:

你不需要修改一行Java代码。OTEL提供了一个Java Agent(一个JAR包),你只需在应用启动时,通过JVM的**-javaagent**参数挂载它。

这个Agent会利用Java的instrumentation机制,在类加载时,动态地修改主流框架(如Spring MVC, Dubbo, gRPC, OkHttp, JDBC, Redis客户端, MQ客户端等)的字节码,自动地在方法入口和出口处,注入创建Span、传递Trace ID的逻辑。

4.3 Java实战:点亮全链路地图

- 下载Agent: 从OpenTelemetry的GitHub Release页面,下载最新的opentelemetry-javaagent.jar。

- **配置并启动应用:**修改我们所有微服务(Gateway, Core, Order)的启动脚本。

1 | -javaagent:/path/to/opentelemetry-javaagent.jar \ |

关键参数解读:

- -javaagent: 挂载Agent。

- otel.service.name: 定义当前服务的名称,这是在UI上区分服务的关键。

- otel.traces.exporter: 指定导出器类型。otlp是OTEL的原生协议。也可以设置为jaeger, zipkin等。

- otel.exporter.otlp.endpoint: 指定后端数据收集器的地址。通常我们会部署一个OpenTelemetry Collector来接收数据,再转发给Jaeger、Prometheus等。

- 后端展示与分析(以Jaeger为例):当一个秒杀请求完成后,我们可以在Jaeger的UI界面中,搜索它的traceId(这个ID可以从我们的结构化日志中获取)。你将看到一幅震撼的火焰图(Flame Graph):

- 时间轴: 清晰地展示了每个Span的开始时间、持续时长和父子关系。

- 瓶颈定位: 哪个Span最宽,就说明哪一步耗时最长。上图中,我们可以一眼看出是Redis::save这一步耗时最长。

- 错误溯源: 如果某个Span标记为红色,说明该步骤发生了异常。点击它,可以看到详细的异常堆栈信息,甚至可以关联到对应的错误日志。

- **手动埋点(高级用法):**虽然自动探针很强大,但有时我们需要对自己的业务方法进行更精细的追踪。

1 |

|

通过手动埋点,我们可以将一个复杂的业务方法,分解为多个子Span,从而获得更细粒度的性能洞察。

第五部分:三位一体的联动——从“点”到“面”的立体化排障

现在,我们拥有了Logs、Metrics、Traces这三件神器。但它们最强大的地方,在于联动。让我们来复现一个真实的、令人心跳加速的线上故障排查场景。

告警触发: PagerDuty在凌晨2点把你叫醒,告警信息:“[High] Seckill API P99 Latency > 500ms for 5 minutes”。

你的立体化排障流程:

- 第一步:Metrics(从“面”入手,确认影响范围)

- 你打开Grafana的秒杀作战大盘。

- 发现1: “API Gateway P99 Latency”曲线确实在2点左右有一个陡峭的拉升。

- 发现2: 你下钻到各个后端服务的延迟面板。“Seckill-Core Latency”曲线平稳,但“Order-Service Latency”曲线与网关的曲线高度吻合,同样在飙升。

- 初步判断: 问题根源很可能在Order-Service或其下游依赖(MySQL)。

- 第二步:Tracing(沿“线”追踪,定位具体瓶颈)

- 你回到Grafana的延迟面板,它已经与Jaeger集成了。你点击慢请求时间段的一个数据点,Grafana会带你跳转到Jaeger,并自动筛选出那个时间段内的慢请求Traces。

- 你随便点开一个耗时超过500ms的Trace。火焰图一目了然:

- gateway的Span很宽。

- 其子Span seckill-core很窄(说明核心服务没问题)。

- seckill-core发出的MQ消息被order-service消费,这个order-service的Span极宽。

- 在order-service的子Span中,你发现一个名为java-jdbc-statement.execute的Span,占据了整个Trace 90%的时间。

- 精准定位: 问题就出在订单服务执行数据库写入的JDBC操作上。

- 第三步:Logs(深挖“点”,找到根本原因)

- 你在Jaeger的Span详情中,直接复制这个慢请求的traceId: a1b2c3d4e5f6。

- 你打开Kibana,在搜索框中输入:trace.id: “a1b2c3d4e5f6”。

- 瞬间,与这次请求相关的所有服务的、所有日志都被筛选了出来,并按时间排序。你看到:

- gateway的access log。

- seckill-core的“库存扣减成功”日志。

- 关键发现: order-service在执行数据库写入前后,打印了大量的日志,其中反复出现HikariPool-1 - Connection is not available, request timed out after 30000ms。

- 根本原因(Root Cause): 数据库连接池(HikariCP)耗尽!所有业务线程都在等待获取数据库连接,导致请求处理时间急剧增加。

解决与复盘:

你立即通过动态配置中心,临时调大了Order-Service的数据库连接池大小,系统延迟迅速恢复正常。

一场可能需要数小时、涉及多个团队扯皮、翻查海量日志的线上故障,在三位一体的可观测性体系下,被压缩到了短短几分钟。你从一个宏观的“面”(Metrics),定位到一条具体的“线”(Tracing),再深挖到一个精确的“点”(Logs),整个过程行云流水,如同推理小说中的神探破案。

结语:从“建造者”到“通灵者”

在本章超过一万五千字的探索中,我们完成了从一个单纯的系统“建造者”,到能与系统“灵魂”对话的“通灵者”的转变。我们不再满足于让系统“工作”,而是执着于让系统“可被理解”。

我们掌握了:

- 结构化日志的艺术,让每一行Log都成为可供分析的数据。

- 业务指标埋点的技巧,用数字和图表为系统的健康状况绘制心电图。

- 全链路追踪的魔法,用Trace ID串联起分布式世界中破碎的岛屿,绘制出完整的请求地图。

最重要的是,我们学会了如何将这三者联动起来,构建了一个从宏观到微观、从现象到本质的立体化问题诊断体系。

这套可观测性体系,就是我们作为架构师,在面对日益复杂的分布式系统时,保持从容和自信的最大底气。它不是事后的“验尸报告”,而是随系统一同呼吸、一同脉动的“生命体征监测仪”。

我们的“雷神之锤”秒杀系统,现在不仅拥有了强健的体魄,更拥有了一双能洞察自身的“上帝之眼”。但战争还未结束,我们还需要为它注入免疫力,让它能主动抵御未知的风险。

在真正“上战场”之前,对我们手中的核心武器——数据库、缓存、乃至JUC并发包——进行一次极限的、深入骨髓的调优和打磨,是确保胜利的基石。这不仅能极大地丰富我们实战篇章的内容,更能体现出一位资深架构师对底层原理的掌控力和“工匠精神”。