百万架构师成长之路(9):构建微服务“反脆弱”系统的韧性设计之道:降级、熔断与限流的终极指南

导语:欢迎来到混沌的微服务世界

在单体架构的“黄金时代”,工程师们如同钟表匠,面对的是一个精密但相对确定的系统。所有齿轮(组件)紧密耦合,在同一个盒子里(进程)运转,出了问题,一眼就能看到是哪个齿轮卡住了。

然而,当我们踏入微服务架构的分布式丛林,游戏规则彻底改变了。我们面对的不再是精密的钟表,而是一个充满了不确定性的生态系统。网络的一次抖动、节点的瞬时失联、服务的偶尔延迟……这些不再是“如果(if)”会发生的意外,而是“何时(when)”必定会发生的常态。

这种转变,要求我们的思维模式必须从“祈祷不出错”,彻底转向“为失败而设计”。“高可用”不再是机房里一块闪着绿灯的牌子,而是一种动态的、需要我们用汗水和智慧去主动维持的系统状态。想象一下,任何一个服务实例的GC停顿、一次网络抖动、一个慢SQL,都可能像一颗小石子,通过RPC调用链的层层放大,最终触发一场摧毁整个系统的“雪崩效应(Cascading Failures)”。

这篇文章,就是你穿越这片混沌丛林的生存指南。我们将构建一个关于微服务韧性设计的完整认知框架,沿着一条从被动防御(熔断)到主动控制(限流),再到战略取舍(降级),最终实现**体系化验证(全链路压测)**的逻辑路径,一步步解构服务治理的核心支柱。

这不只是一份技术手册,更是一场关于架构权衡、设计哲学与工程智慧的深度复盘。

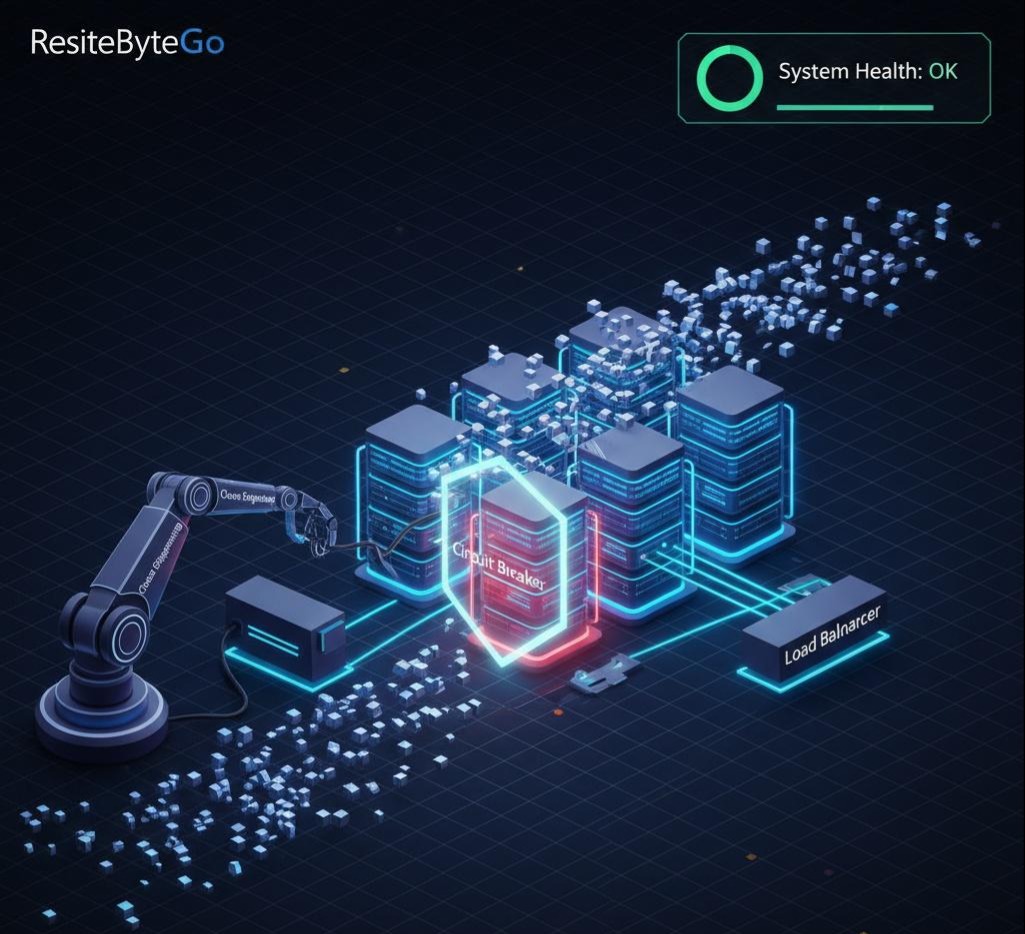

第一章:被动防御的基石——熔断器(Circuit Breaker)

当风暴来袭,一艘船的首要任务不是加速前进,而是关紧所有防水舱门,确保自己不会沉没。熔断器,就是我们系统在面临“雪崩”威胁时,最基础、最关键的“防水舱门”。它要解决两个核心问题:1. 如何聪明地“感知”到风暴? 2. 如何果断地“关门”并择机“重开”?

1.1 问题的根源:同步阻塞下的资源耗尽

让我们来看一个经典的“血案”现场:服务A(订单服务)同步调用服务B(库存服务)。服务B因故响应从50ms飙升至5s。很快,服务A的Tomacat线程池被等待B响应的线程占满,无法处理任何新请求,事实性宕机。故障最终向上游蔓延,火烧连营。

问题的本质是什么? 在同步调用模型下,调用方与被调用方的故障是强耦合的。调用方以耗尽自身关键处理资源(线程)为代价,去等待一个低概率成功的响应,从而引发了系统性的资源枯竭。

1.2 故障感知:从周期计数器到滑动窗口的演进

熔断决策的准确性,直接取决于其故障感知模型的精度。

模型一:周期计数器(Periodic Counter)

- 逻辑:“在T秒的时间窗口内,如果失败次数超过N次,则触发熔断”。

- 核心缺陷:边界毛刺问题(Boundary Spike Problem)。该模型无法识别跨越统计周期边界的流量突刺。例如,一个阈值为100 QPS的系统,在[0.5s, 1.0s]和[1.0s, 1.5s]两个时间片内分别承受了100个请求,各自看均未超限。但实际上,系统在[0.5s, 1.5s]这1秒的真实时间窗内承受了200 QPS的冲击。周期计数器对此完全失明。

模型二:滑动窗口(Sliding Window)

- 核心原理:将一个大的统计周期(例如10秒)分割成多个更细粒度的“桶”(Bucket)(例如10个1秒的桶)。请求的统计数据被原子地累加到当前时间点对应的桶中。决策时,聚合当前统计周期内所有有效的桶的数据。

- 优势:通过时间维度的细粒度切分和滚动聚合,实现了对任意时间区间的平滑统计,从根本上解决了“边界毛刺”问题。

【技术深潜:Sentinel LeapArray的优雅实现】

为了兼顾高并发性能与统计精度,Sentinel的滑动窗口实现LeapArray是一个典范。

数据结构: 它并非使用普通数组,而是 java.util.concurrent.atomic.AtomicReferenceArray>。WindowWrap 封装了每个时间桶(MetricBucket),而 AtomicReferenceArray 保证了在高并发场景下对时间桶的替换操作是线程安全的、无锁的。

窗口定位: 通过 currentTimeMillis / windowLengthInMs 计算出当前请求归属的时间桶ID,再通过取模运算映射到环形数组的索引上。

“滑动”的实现: 它没有真正的数据“滑动”或迁移。而是采用*“懒惰重置”(Lazy Reset)*策略。当写入数据时,若发现目标索引上的时间桶已过期,它会就地重置该桶(resetWindowTo),赋予其新的时间窗口ID并清空统计数据。此设计避免了全局锁或大规模数据复制,是一种兼具精度与性能的极致实现。

1.3 隔离与恢复:三态自动机的设计哲学

精确地感知到故障,仅仅是完成了第一步。接下来的问题是:然后呢? 我们该如何响应这个故障信号?一个简单的“发现故障就切断,永不恢复”的开关显然过于粗暴,因为它无法应对下游服务可能自我修复的场景。我们需要的是一个更智能、自动化的响应机制,它不仅能在危险时果断“拉闸”,还能在风平浪静后小心翼翼地“试探送电”。

这正是熔断器经典的三态(Closed, Open, Half-Open)状态机的设计精髓,它为系统赋予了故障隔离与自我修复的闭环能力。

- CLOSED (闭合状态):信任但验证

此为系统的常规状态,所有请求被允许通过,仿佛电路是闭合联通的。然而,它并非高枕无忧,滑动窗口在后台像一个忠诚的哨兵,持续收集着每次调用的健康数据(成功、失败、超时)。当在一个统计周期内,总请求量达到了触发计算的最小阈值(如minNumberOfCalls=100次),且失败率或慢调用比例超过了预设的红线(如failureRateThreshold=50%)时,状态机发生关键跃迁:从CLOSED切换到OPEN。

- OPEN (断开状态):快速失败与隔离

进入此状态,意味着熔断器已经确认下游服务出现了严重问题。此时,所有后续指向该服务的请求将立即在调用方被拒绝(例如,框架抛出CallNotPermittedException),而不再发起任何真实的网络调用。这个动作实现了两个至关重要的目标:

- 保护调用方:避免其宝贵的线程资源被无休止的等待所耗尽,维持自身核心服务的可用性。

- 为下游减压:停止对已处于故障状态的下游服务施加任何新的压力,给予其宝贵的恢复时间窗口。 此状态会持续一个预设的“熔断持续时间”(如waitDurationInOpenState=60秒),在此期间,系统以最小的代价处理异常,实现了“快速失败”。

- HALF-OPEN (半开状态):探测性恢复

在OPEN状态的持续时间结束后,状态机 不会贸然地完全恢复,而是自动切换至审慎的HALF-OPEN状态。系 统 会像一个排雷 工兵,允许一小部分“探测”请求(由permittedNumberOfCallsInHalfOpenState定义,例如10个)通过,去检验下游服务是否已经恢复。这是熔断器**自我修复(Self-healing)**能力的核心体现。

- 恢复决策:熔断器会严密监控这批探测请求的结果。如果失败率依然很高,说明下游仍处故障,状态机将立刻退回OPEN状态,并开始新一轮的熔断持续周期。如果这批请求的成功率恢复到健康水平,熔断器则认为下游服务已康复,便会切换回CLOSED状态,恢复正常业务流量。

架构师的思考:熔断策略的权衡

熔断的触发条件,通常有“异常比例/数量”和“慢调用比例”两种核心策略。前者适用于明确抛出异常的场景;后者则专门针对下游服务“假死”(不抛异常,但RT极慢)的场景,这种故障对系统的危害往往更大。在设计时,需要分析下游服务的典型故障模式,将两者结合使用,例如配置一个“或”逻辑:当异常率超过50% 或 慢调用(RT > 500ms)比例超过60%时,触发熔断。

第二章:主动控制的核心——限流(Rate Limiting)

如果说熔断是被动应对服务“质变”(故障),那么限流就是主动控制流量“量变”(冲击)。它不再是等问题发生后去补救,而是在问题发生前进行预防。限流的本质,是在系统处理能力的上限与海量用户请求之间,建立一道可控的“阀门”。

2.1 流量控制算法的数学模型与权衡

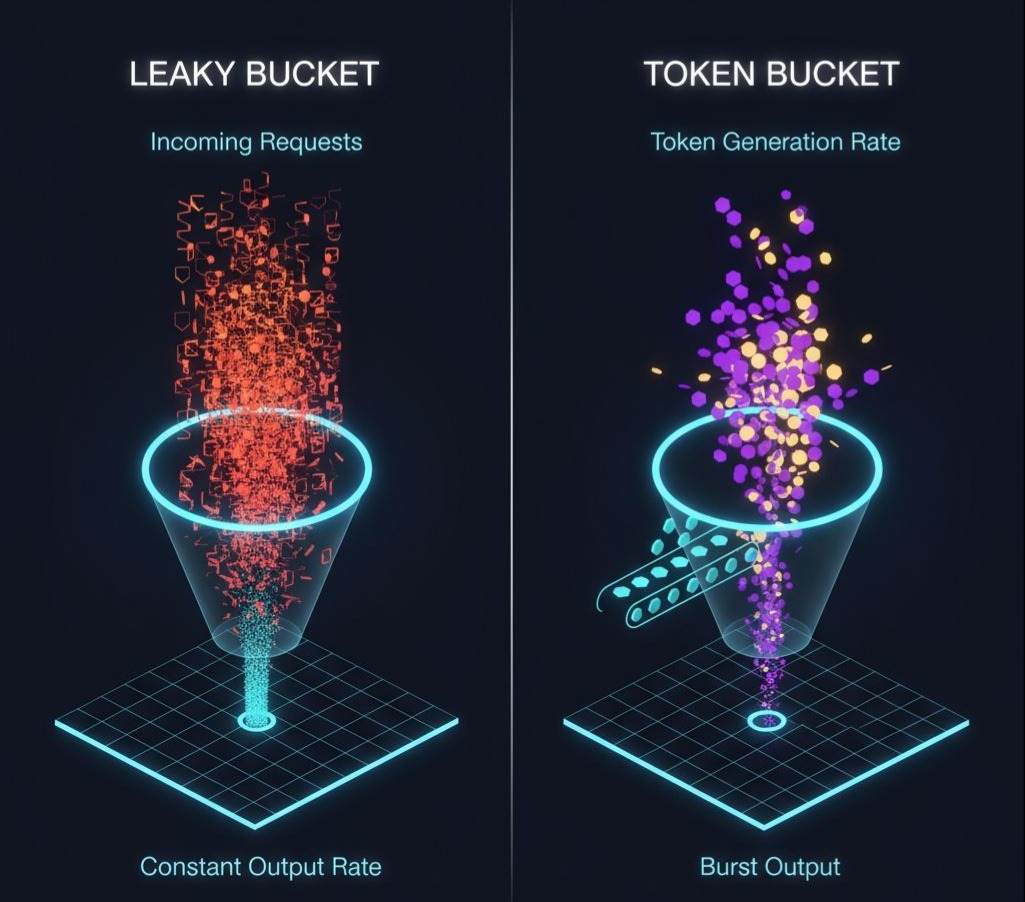

- 漏桶算法 (Leaky Bucket):绝对匀速的管道

- 模型:将请求视为水,系统处理能力视为桶底固定漏孔。水以任意速率流入,但以恒定速率流出。桶满则溢出。这是一种典型的流量整形(Traffic Shaping)。

- 利弊分析:它的最大优点是能强行将不规则的突发流量“熨烫”成平滑的、速率固定的流量,从而为下游系统提供极致稳定的保护。但这也是它的缺点:过于僵化。即使系统当前资源充足,它也无法处理超出固定速率的任何突发请求,导致响应延迟增加和资源利用率降低。

- 适用场景:需要严格保护处理能力绝对固定的下游系统,如调用有明确QPS限制的第三方短信API、向日志系统推送数据等,这些场景下,平滑比响应速度更重要。

- 令牌桶算法 (Token Bucket):可预支的未来

- 模型:系统以恒定速率向一个固定容量的桶里放令牌。请求需获取令牌才能被处理。

- 利弊分析:令牌桶的核心优势在于其允许突发流量(Allowing Bursts)。当系统空闲时,令牌会不断累积,直到桶满。当流量洪峰到来时,这些累积的令牌可以被瞬间消耗,使得系统在短时间内能够以远超平均速率的速度处理请求。例如,一个速率为100 QPS、桶容量为200的令牌桶,意味着它在任何时刻都能立即处理掉一个200个请求的流量脉冲,然后恢复到每秒处理100个请求的能力。

- 适用场景:绝大多数需要兼顾平均速率控制和突发流量处理的Web应用。它在性能和保护之间取得了绝佳的平衡。

2.2 超越算法:Sentinel的流控策略与效果

现代流控框架远不止于基础算法,它们提供了更贴近业务场景的流控“效果”,让限流策略的制定更加精细。

- 直接拒绝 (RuleConstant.CONTROL_BEHAVIOR_DEFAULT):这是最基础、最常见的模式。当QPS或并发线程数超过阈值时,直接抛出FlowException,简单明了。适用于那些可以接受部分请求失败的场景。

- 预热 (Warm Up, RuleConstant.CONTROL_BEHAVIOR_WARM_UP):这是一个非常人性化的设计,专门应对服务的“冷启动”场景。一个刚刚启动的服务,其内部的JIT编译器尚未完成热点代码优化,数据库连接池尚未填满,各类缓存也处于冷状态,此时它的处理能力远未达到巅峰。如果一上来就用最大阈值去迎接流量,很容易被打垮。预热模式下,阈值会从一个较低的值开始,在一个预设的预热时长(warmUpPeriodSec)内,平滑地增长至配置的上限,给足系统“热身”的时间。

- 匀速排队 (Rate Limiter, RuleConstant.CONTROL_BEHAVIOR_RATE_LIMITER):这是漏桶思想的经典应用。当请求QPS超过阈值时,它不会直接拒绝,而是让请求进入一个虚拟队列排队等待。每个请求的通过时间间隔被严格控制为1 / QPS。这种模式的价值在于“削峰填谷”,将瞬时的流量洪峰转化为平稳的、对下游系统无冲击的请求流。适用于某些异步任务处理、或确保对下游数据库的写入操作平缓进行的场景。

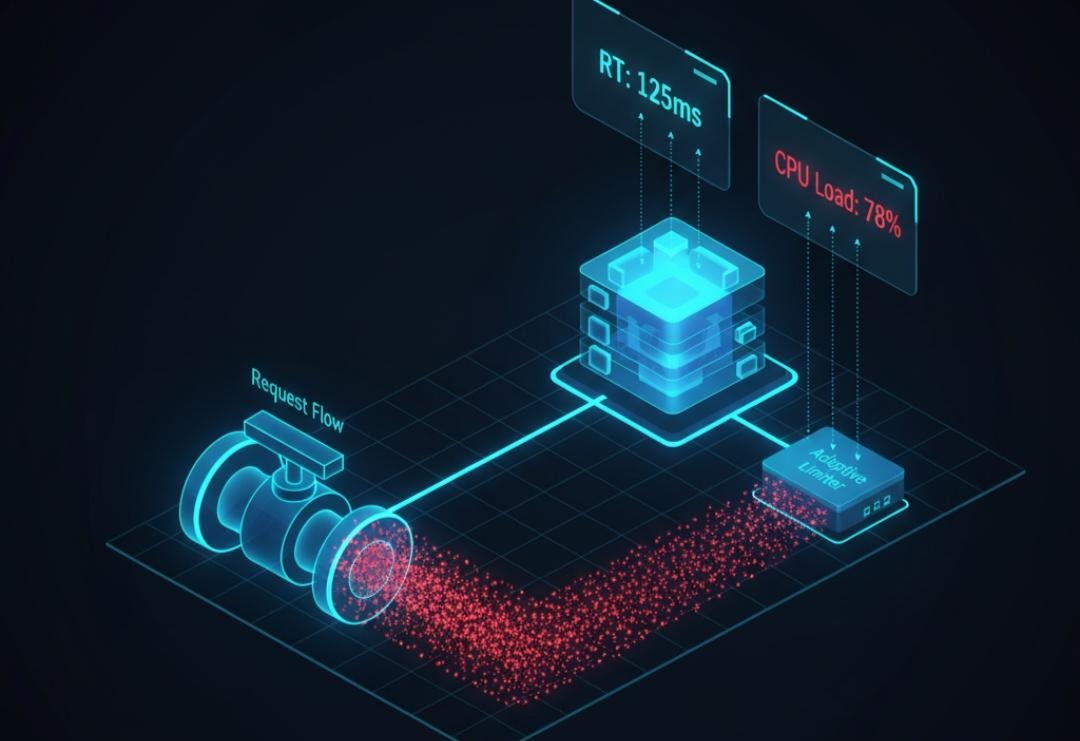

2.3 限流的终局:自适应限流——从“静态规则”到“动态反馈”

所有固定阈值的限流,都面临一个灵魂拷问:这个阈值到底设多少才合适?设高了怕扛不住,设低了又浪费资源。而且,系统的处理能力本身就是动态变化的(受GC、其他服务负载等影响)。

- 核心思想转变:从监控**“入口QPS”(开环控制),转为监控“系统出口”的健康指标**(闭环负反馈控制)。我们不再盲目地限制“进来多少”,而是根据“系统处理得怎么样”来动态决定阀门开多大。

- 监控指标:选择两个最能反映系统真实负载的指标:平均响应时间(RT)和CPU使用率。

- 决策逻辑 (以Sentinel的系统自适应限流为例):

- 理论基础:基于利特尔法则(Little’s Law: L = λW),即系统中的并发数 = 入口QPS * 平均RT。

- 控制模型:系统设定一个健康承载的RT或CPU“水位线”。当监控到实际RT开始飙升或CPU持续高位,系统就推断出当前入口QPS已超出处理能力。此时,系统会根据当前RT和并发数,反向推导出一个当前能承载的最大QPS,并以此作为动态限流阈值,开始拒绝超出的请求。

自适应限流,标志着服务治理从“基于规则的静态管理”向“基于反馈的动态自调节系统”的认知跃迁。

第三章:战略取舍的艺术——降级(Degradation)

当熔断和限流的警报都已拉响,说明系统正处于极限承压状态。此时,我们必须像一位战地指挥官,做出艰难的战略取舍:主动放弃“次要阵地”,以保全“核心战役”的胜利。降级,并非技术故障,而是一种有计划、有预案的主动行为,是架构在资源与业务价值之间进行的优雅妥协。

3.1 降级的决策模型:功能、数据与体验的权衡

降级不是一个简单的技术开关,而是一套涉及产品、技术和用户体验的综合预案。

- 功能降级 (丢车保帅)

- 思考:在用户的核心路径上,哪些功能是“必须有”的,哪些是“可以有”的?在电商商品详情页,用户能看到商品主图、价格并成功“加入购物车”是核心;而“个性化推荐”、“用户问答”、“买家秀”则是锦上添花。当系统负载过高时,果断降级这些非核心模块,可以直接不展示,或用一个全局预缓存的静态TOP榜单作为兜底,将宝贵的计算和I/O资源留给交易主路。

- 实现:通常通过配置中心下发降级开关,应用在渲染页面或处理API请求时,根据开关状态决定是否调用非核心服务。

- 数据降级 (牺牲一致性/实时性)

- 思考:为了保证核心功能可用,我们是否可以容忍数据在一定时间内的不一致或延迟?电商库存显示是典型例子。正常情况下实时查询数据库,压力大时,降级为读取一份1分钟前由后台任务生成的Redis缓存快照。

- 权衡:这样做的代价是,用户看到的库存可能不是100%精准,有极小概率下单时发现无货。但收益是巨大的:它保住了“加入购物车”和“下单”的主流程,避免了数据库被海量的实时库存查询压垮。这种用最终一致性换取高可用的策略在很多场景下是值得的。

- 体验降级 (保证能用,但没那么好用)

- 思考:在不影响核心功能的前提下,能否通过牺牲一些非关键的用户体验来换取系统资源的节省?例如图片服务,正常情况返回高清原图,降级后,所有图片请求都强制返回经过压缩的、文件体积更小的缩略图。

- 效果:页面加载会更快,极大地节省了服务器带宽和I/O,但图片清晰度下降。对于用户来说,虽然体验稍差,但网站的核心功能依然可用,远胜于看到一个加载不出来的白屏。

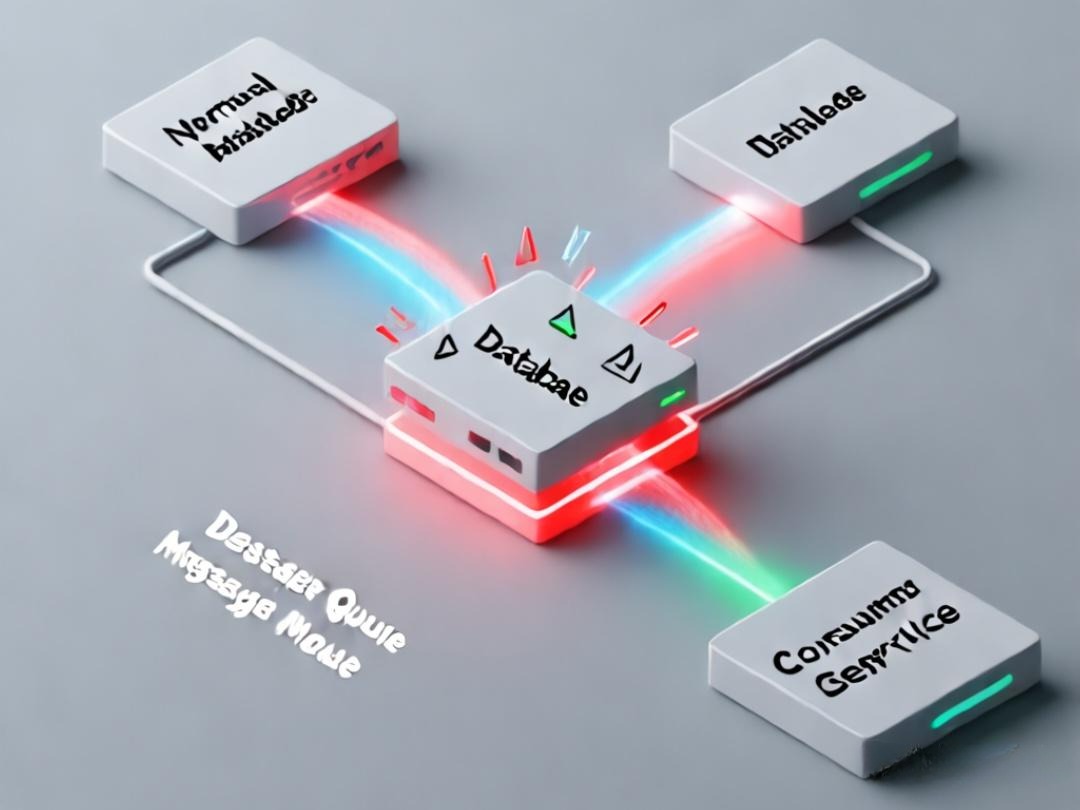

3.2 降级的终极战术:“写”操作的异步化改造

“读”操作降级相对容易,而“写”操作(如创建订单)降级的核心是数据绝不能丢失。

- 核心战术:同步转异步(Synchronous to Asynchronous)

- 触发条件:通过实时监控,当核心数据库(如订单库)的负载、连接池使用率或慢查询比例超过预设的警戒线时,自动触发写降级预案。

- 请求暂存:下单接口的业务逻辑发生改变。不再直接调用订单服务进行同步的数据库写入,而是将包含订单所有必要信息的核心数据(用户ID、商品ID、价格等)序列化后,快速发布到一个高可用、高吞吐的消息队列(Message Queue,如Kafka或RocketMQ)。MQ的选择至关重要,它必须是高可靠、可持久化的。

- 快速响应与用户预期管理:消息成功发布到MQ后,立即向用户返回“下单成功,订单处理中,请稍后在您的订单列表中查看”的友好提示。前端UI的配合改造是成败的关键,必须明确告知用户这是一个异步过程,管理好用户预期,避免用户因未立即看到订单而重复提交。

- 异步补偿处理:在系统后端,部署一个独立的消费者服务集群,订阅该MQ Topic。该服务以可控的速率,从MQ中拉取订单数据,进行持久化的数据库写入操作。此过程需重点解决的技术挑战:

- 消息幂等性:确保同一条订单消息即使被重复消费,也只会在数据库中创建一次订单。

- 失败重试与死信队列:设计健壮的重试机制,对于无法处理的消息,能自动进入死信队列,供后续人工干预。

- 数据对账:建立后台对账机制,定期校验MQ中的消息与最终落库的数据是否一致。

写降级,本质上是用**“最终一致性”换取了系统在极端压力下的“核心写操作的可用性”**。

第四章:工具选型:Sentinel vs. Hystrix 的巅峰对决

理解了熔断、限流、降级的核心思想后,选择合适的工具来实现它们至关重要。在Java生态中,Netflix的Hystrix是该领域的先驱,而阿里的Sentinel则是后来居上的集大成者。

4.1 设计哲学的分野

- Hystrix:其核心是基于线程池的资源隔离。它将对不同服务的调用封装在独立的线程池中,当某个服务出现问题时,只会耗尽其对应的线程池资源,而不会影响到其他服务的调用。这是一种基于“命令模式”的重量级隔离方案。

- Sentinel:其核心是基于滑动窗口和并发线程数的流量控制。它不强制要求线程池隔离,而是通过更轻量级的信号量隔离或直接通过滑动窗口算法来统计和控制调用。它的设计目标是更低的性能损耗和更高的灵活性。

4.2 功能矩阵对比

| 特性 | Hystrix | Sentinel | 备注 |

|---|---|---|---|

| 资源隔离 | 线程池隔离 (主要), 信号量隔离 | 信号量隔离 | Hystrix的线程池隔离是其标志,但也带来了线程切换的开销。Sentinel更轻量。 |

| 熔断降级 | 支持 (基于异常比例) | 支持 (异常比例, 慢调用比例, 异常数) | Sentinel的熔断策略更丰富,特别是慢调用比例熔断,对付“假死”服务非常有效。 |

| 流量控制 | 较弱 (仅信号量限流) | 非常强大 (QPS, 并发线程数, 调用关系, 系统自适应) | 这是Sentinel的核心优势。它提供了丰富的流控维度和效果(预热、排队等)。 |

| 系统自适应保护 | 不支持 | 支持 | Sentinel可以根据系统负载(RT, CPU)自动调整限流阈值,是其一大亮点。 |

| 动态配置 | 支持 (需整合Archaius) | 原生支持, 扩展性强 | Sentinel能轻松对接主流配置中心(Nacos, Apollo),实现规则的动态推送。 |

| 控制台 | 有 (Hystrix Dashboard, Turbine) | 功能强大且开箱即用 | Sentinel Dashboard提供了实时监控、规则配置、集群流控等一站式能力。 |

| 社区状态 | 进入维护模式 | 社区活跃, 持续演进 | Netflix已宣布Hystrix不再进行新功能开发,而Sentinel是CNCF的活跃项目。 |

4.3 架构师的选型建议

对于历史遗留项目,如果已经深度集成了Hystrix,且运行稳定,可以继续维护。

但对于所有新项目或需要进行技术栈升级的项目,Sentinel是毫无疑问的更优选择。原因如下:

- 轻量级与高性能:无线程池模式避免了不必要的线程切换开销,对应用的性能影响更小。

- 功能的全面性:在流量控制和熔断策略上,Sentinel提供了远超Hystrix的灵活性和丰富度。系统自适应限流更是解决了静态阈值配置的痛点。

- 活跃的生态与未来:作为CNCF下的活跃项目,Sentinel拥有强大的社区支持和明确的演进路线,能更好地拥抱云原生时代。

Hystrix是一位值得尊敬的开拓者,它定义了韧性设计的基本模式。而Sentinel则站在巨人的肩膀上,以更现代、更全面、更高性能的设计,成为了当下服务治理领域的首选。

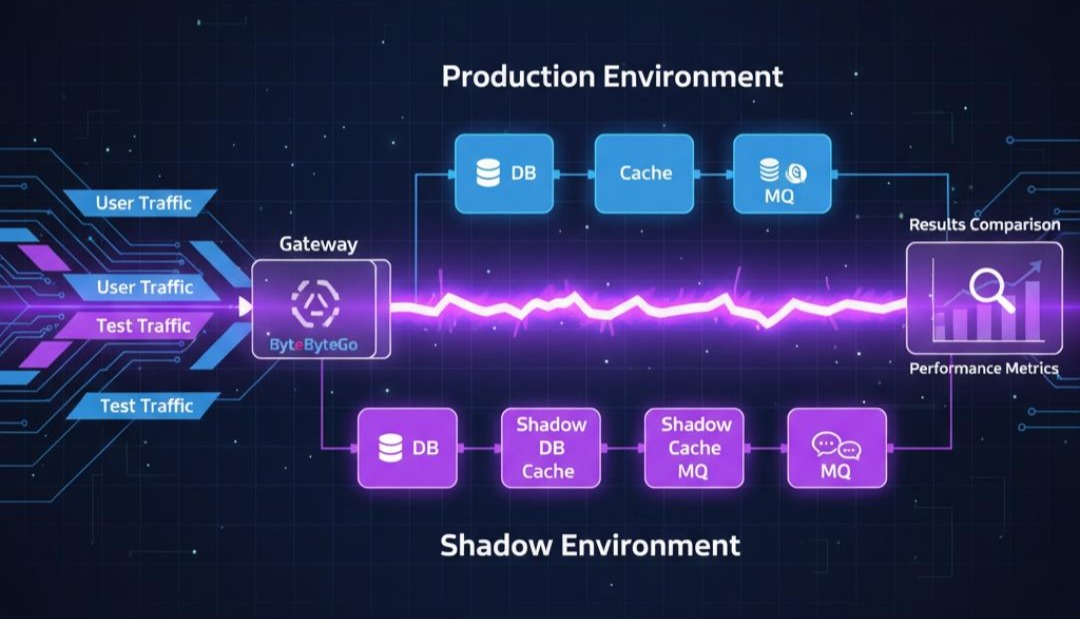

第五章:体系化验证的闭环——全链路压测工程

我们已经为系统构建了熔断、限流、降级等多道防线。然而,这些防御工事的参数配置是否合理?预案在真实高压下能否被精准触发?理论设计必须经过实战的检验。

全链路压测并非一次常规的QA测试,而是一项复杂的、跨职能的系统性工程。它的目标是在生产环境中,通过模拟真实的用户行为和流量洪峰,来验证系统端到端的性能容量、发现潜在瓶颈、并检验高可用体系的有效性。

我们将这个工程拆解为四个核心阶段。

第一阶段:规划与准备 —— 定义目标、范围与规则

压测的成功与否,很大程度上取决于前期的规划是否清晰。

- 目标定义 (Goal Definition): 从业务目标到技术指标

压测的驱动力必须来自业务。技术团队不能凭空设定性能目标。正确的流程是:

- 业务输入:与产品、运营团队协作,明确压测所要模拟的业务场景。例如,“支撑双十一大促,预计订单峰值达到每分钟12万单”。

- 指标换算:将业务目标拆解为具体的技术性能指标(KPIs)。“12万单/分钟”意味着核心的订单创建接口需要承载 2000 TPS (Transactions Per Second)。同时,需要定义可接受的服务质量标准,如“99%的请求响应时间(P99 Latency)必须在500ms以内,成功率不低于99.99%”。

- 达成共识:这些指标一旦确定,就成为整个压测项目的“验收标准”。

- 范围梳理 (Scope Identification): 明确核心链路与依赖

对涉及的系统进行全面的梳理,界定本次压测的边界:

- 核心链路:识别出承载核心业务逻辑的请求路径。例如,电商的“用户登录 -> 浏览商品 -> 加入购物车 -> 创建订单 -> 发起支付”就是一条典型的核心链路。压测资源将主要聚焦于此。

- 依赖分析:绘制出核心链路所依赖的所有上下游服务。对于每一个依赖,都需要明确其在压测中的处理方式:

- 强依赖 (同步调用):必须纳入压测范围。

- 弱依赖 (异步调用/非关键功能):可以考虑降级或使用挡板。

- 外部依赖 (第三方支付、物流查询等):绝对不能直接压测,必须使用挡板(Mock Server)进行模拟。

- 项目治理 (Project Governance): 建立变更控制流程

为了保证压测结果的有效性和可重复性,必须建立严格的**变更控制(Change Control)**机制。在压测周期内,核心链路涉及的所有应用、配置、基础设施的变更都必须被冻结(Code Freeze)。任何必要的改动,都必须通过压测项目组的评估和审批,以避免无关变量干扰压测结果。

第二阶段:技术实现 —— 数据隔离与流量染色

这是压测技术含量最高的部分,核心是解决一个矛盾:如何在真实的生产环境进行破坏性测试,同时确保对线上用户和数据零影响。

1. 压测环境:为什么必须是生产环境?

独立的测试环境永远无法100%复制生产环境的复杂性,包括:网络拓扑与延迟、硬件配置差异、历史数据量级与分布、以及复杂的系统配置。基于测试环境的压测结论往往过于乐观,缺乏现实指导意义。因此,生产环境压测是唯一能够真实反映系统能力的方式。

2. 核心机制:全链路流量染色 (Traffic Tagging)

实现生产环境安全压测的基石是流量染色。

- 入口标记:在流量的源头(如网关、压测客户端),为所有压测请求附加一个特殊的、全链路透传的标识。最常见的方式是使用HTTP Header,例如

X-Stress-Test: true。 - 链路透传:该标识必须在整个调用链中(RPC、消息队列、异步线程池等)被完整地传递下去。这通常需要对基础框架和中间件进行适配改造。

3. 数据隔离 (Data Isolation): 构建并行的“影子世界”

有了压测标识后,数据隔离就成为了可能。通过对数据存储层客户端进行扩展(通常使用无侵入的Java Agent字节码增强技术),实现压测流量的自动路由:

- 数据库 (DB):识别到压测标识后,将SQL语句路由到影子库或影子表。

- 缓存 (Cache):识别到压测标识后,为缓存Key自动添加特定前缀(如

pt_),实现物理隔离。 - 消息队列 (MQ):识别到压测标识后,将消息的生产和消费指向专用的影子Topic/Queue。

- 搜索引擎 (ES):识别到压测标识后,将读写操作指向影子索引。

这套机制确保了压测数据在一个隔离的逻辑空间内闭环,不会污染任何真实的业务数据。

第三阶段:执行与分析 —— 迭代优化与瓶颈定位

压测执行是一个动态的、循环往复的过程。

1. 预热 (Warm-up)

在正式施压前,使用小流量对系统进行预热。目的是为了触发JVM的JIT编译、填充各级缓存、预创建数据库连接池等,使系统达到一个稳定运行的状态,避免“冷启动”效应对压测结果的干扰。

2. 梯度施压 (Ramped Load Injection)

采用阶梯式或斜坡式的策略逐步增加并发负载,而不是瞬间达到目标值。这种方式的好处在于:

- 安全:可以实时监控系统各项指标的变化,一旦出现恶化趋势,能及时中止测试。

- 定位拐点:能够清晰地观察到系统在哪个负载水平开始出现性能瓶颈(例如,RT急剧上升,CPU使用率达到饱和)。

3. 迭代调优循环 (Iterative Tuning Cycle)

压测的核心在于“发现问题 -> 定位问题 -> 解决问题 -> 验证效果”的闭环。

- 观测 (Observe):通过监控系统(APM、基础设施监控、业务监控)发现性能瓶颈。例如,观察到订单服务P99 RT超过1秒。

- 定位 (Analyze):利用APM的调用链追踪和性能剖析工具,深入分析瓶颈根源。例如,发现是由于一个慢SQL查询导致。

- 优化 (Optimize):由相关领域的工程师(开发、DBA等)实施优化。例如,为慢SQL添加索引。

- 再验证 (Re-validate):重新执行压测,验证优化措施是否有效,并观察瓶颈是否转移。

4. 韧性验证 (Resilience Validation)

在达到一定负载水平时,主动进行**故障注入(Failure Injection)**测试。例如,随机关闭几个服务实例、模拟网络延迟、提高磁盘I/O负载等。目的是验证我们之前设计的熔断、降级、限流等高可用策略是否能够被正确、及时地触发。

第四阶段:常见挑战与解决方案

理论流程清晰,但实际执行中总会遇到各种棘手的问题。

挑战一:压测数据的真实性与有效性

- 问题:使用少量静态数据(如一个测试账号、一个测试商品)进行压测,会导致缓存命中率极高,压测结果严重失真,无法反映真实负载。

- 解决方案:压测数据必须模拟线上真实的数据分布和业务状态。通常采用生产数据脱敏后导入影子库的方案。对于有状态的写操作(如优惠券使用、库存扣减),需要开发专门的数据构造和清理脚本,确保每次压测的初始状态一致。

挑战二:外部与内部依赖的管理

- 问题:核心链路常常依赖于许多我们无法控制的服务(如第三方API、其他业务线的非核心系统),这些依赖方往往无法承受压测流量。

- 解决方案:建立详尽的依赖关系清单。与每个依赖方沟通,确认其是否能支持压测。如果不能,必须为其开发功能完备的挡板(Mock Server)。挡板不仅要能模拟成功场景,更关键的是要能模拟各种异常和超时,用以检验系统的容错能力。

挑战三:组织协同与项目推进

- 问题:全链路压测涉及部门多、链路长,容易因沟通不畅、职责不清而导致项目延期。例如,DBA创建影子库需要排期,SRE调整监控告警需要走流程。

- 解决方案:压测必须作为高级别专项项目来运作,并获得管理层的明确授权和支持(Executive Sponsorship)。成立一个跨职能的虚拟项目组,建立高效的即时沟通渠道,并制定清晰的项目计划和每日站会制度,确保信息透明和问题快速响应。

挑战四:性能指标的正确解读

- 问题:过度关注**平均响应时间(Average Latency)**会掩盖严重的长尾问题。平均值可能很低,但少数用户的体验可能极差。

- 解决方案:必须关注分位值指标,特别是P95、P99和P999延迟。这些指标更能反映用户群体的真实体验。例如,P99延迟为2000ms意味着有1%的用户请求需要等待2秒以上,这通常是系统出现问题的强烈信号。性能分析和优化的目标应该是降低高分位值的延迟,而不仅仅是平均值。

结语:架构师的终局——构建反脆弱的数字系统

从被动防御的熔断,到主动控制的限流,再到战略取舍的降级,最终通过体系化、充满挑战的全链路压测进行验证——我们走完了一条从“应对已知故障”到“管理未知不确定性”的完整认知路径。

这一切工程实践,最终都指向一个共同的架构哲学:构建一个**“反脆弱(Antifragile)”**的系统。

一个“健壮”的系统,能在压力下保持形态,但终有其极限。而一个“反脆弱”的系统,则能够在混乱和冲击中学习、受益,并演化得更加强大。每一次熔断,都是对依赖的重新审视;每一次限流,都是对容量的精准丈量;每一次降级,都是对价值的深刻洞察;而每一次充满泥泞的压测,都是系统进行自我进化、最宝贵的学习循环。

作为架构师,我们的终极使命,不是交付一个没有错误的代码集合,而是设计一个能够拥抱失败、自我修复、持续进化的、充满生命力的数字有机体。

这,就是在混沌中所建立的秩序,也是我们这份职业的迷人之处。